Google a récemment annoncé une technologie très prometteuse pour piloter tout type d’appareil électronique. Son nom: Project Soli. Il s’agit d’un système permettant de détecter dans l’espace le positionnement des doigts… et le moindre de leurs mouvements. Il est capable d’identifier à tout moment position et déplacement avec une très haute précision. De ces informations, on peut alors en déduire des demandes d’ordres ou de commandes qui seraient habituellement captées par une souris, un clavier, un écran tactile, …. Nous voici donc en présence d’une nouvelle façon d’interagir avec nos appareils de manière assez naturelle.

Soli est un périphérique haptique reprenant à son compte l’idée de base du Leap Motion. Un petit composant matériel est utilisé pour identifier les gestes des mains et des doigts afin de les transcrire en ordres à destination de la machine. La ressemblance s’arrête là. Le Leap Motion et le Projet Soli ne partagent pas la même technologie embarquée. Les nombreux déçus du Leap Motion n’en seront que plus rassurés. En effet ce dernier n’a jamais réussi à percer du fait de problèmes de reconnaissances gestuelles fines et de compatibilité avec les logiciels habituels. Sur ces 2 points, le Projet Soli est très attendu.

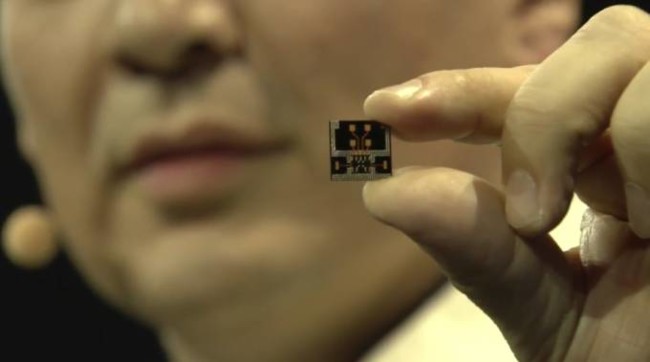

La technologie est embarquée sur une puce électronique. Il s’agit donc d’un dispositif ultracompact pouvant être embarqué sur tous nos appareils mobiles tels que les smartphones, les tablettes et autres smatwatches. Il pourra également être disponible sur bon nmbre d’objets connectés qui sauront exploiter la finesse de détection des mouvements. Qui n’a jamais rêvé d’allumer les lumières de sa maison d’un simple claquement de doigt ou de la passer en mode tamisée d’un simple geste du pouce se promenant sur l’index de la même main?

Ce radar miniature tient sur une puce électronique de seulement 9 mm de large. Cette miniaturisation est un gage de succès du projet. De nombreuses prouesses ont été accomplies en ce sens. Il parait qu’en 10 mois seulement, les équipes de Google ATAP (Advanced Technology and Projects) sont passés d’un système ayant la taille d’une boîte à pizza à une puce plus petite qu’une carte SD.

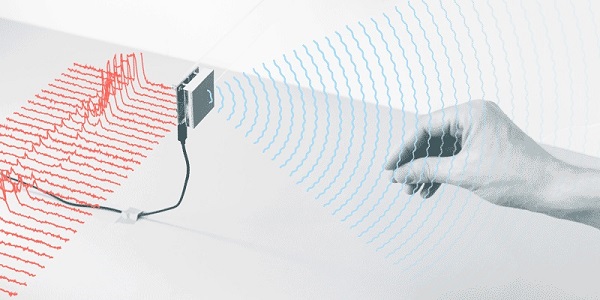

Elle émet des ondes radio dans le spectre des 60 GHz. Lorsque ces ondes rencontrent les obstacles recherchés, elles rebondissent sur la main et les doigts. C’est de cette manière que Google peut en déduire la position de nos membres digitaux dans l’espace à l’échelle du millimètre. La finesse de la détection est comparée à un traitement pouvant analyser l’équivalence de 10 000 images par seconde. Tout de même!

Le Projet Soli développe un nouveau capteur d’interaction en utilisant la technologie radar. Le capteur peut suivre les mouvements sub-millimétriques à haute vitesse et d’une précision inégalée.

Telles sont les promesses de cette nouvelle technologie. Elle a été pensée pour être produite à une grande échelle et pouvant être intégrée dans de petits appareils et des objets du quotidien. On devrait en entendre parler dans les années à venir si, comme il y paraît, Google souhaite l’utiliser comme fer de lance de son avancée dans le secteur des objets connectés.

Les équipes de Google travaillent actuellement à la finalisation de la carte de développement (prototype) et de l’API pour que les développeurs puissent commencer à “jouer” avec dès la fin de cette année.

Pour se rendre un peu plus compte des possibilités de cette nouvelle interface Homme machine naissante je vous conseille la vidéo ci-dessous. Vous m’en direz des nouvelles!

Soyez le premier à commenter